Pokud chcete na svém počítači provozovat Large Language Models nebo LLM, jeden z nejjednodušších způsobů, jak toho dosáhnout, je přes Ollama. Ollama je výkonná platforma s otevřeným zdrojovým kódem, která nabízí přizpůsobitelné a snadno dostupné prostředí AI. Usnadňuje stahování, instalaci a interakci s různými LLM, aniž byste se museli spoléhat na cloudové platformy nebo vyžadovat jakékoli technické znalosti.

Kromě výše uvedených výhod je Ollama poměrně lehká a je pravidelně aktualizována, díky čemuž je docela vhodná pro vytváření a správu LLM na místních počítačích. Nepotřebujete tedy žádné externí servery ani složité konfigurace. Ollama také podporuje více operačních systémů, včetně Windows, Linux a macOS, a také různá prostředí Docker.

Stažení a instalace Ollama

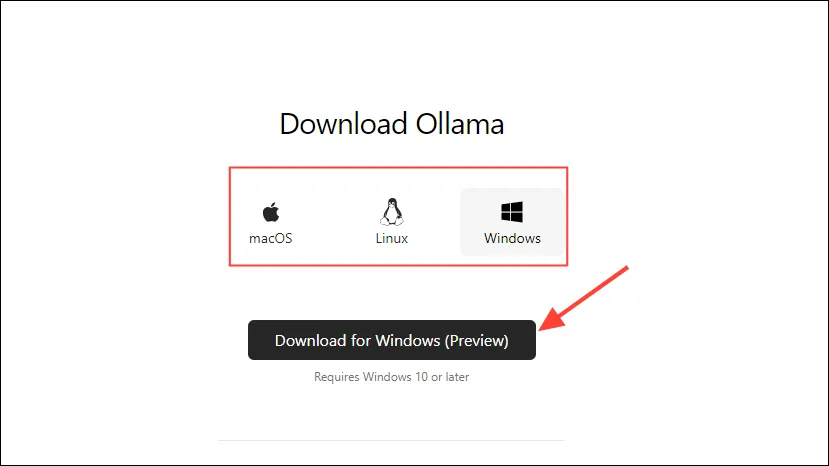

- Nejprve navštivte stránku stahování Ollama a vyberte svůj operační systém před kliknutím na tlačítko ‚Stáhnout‘.

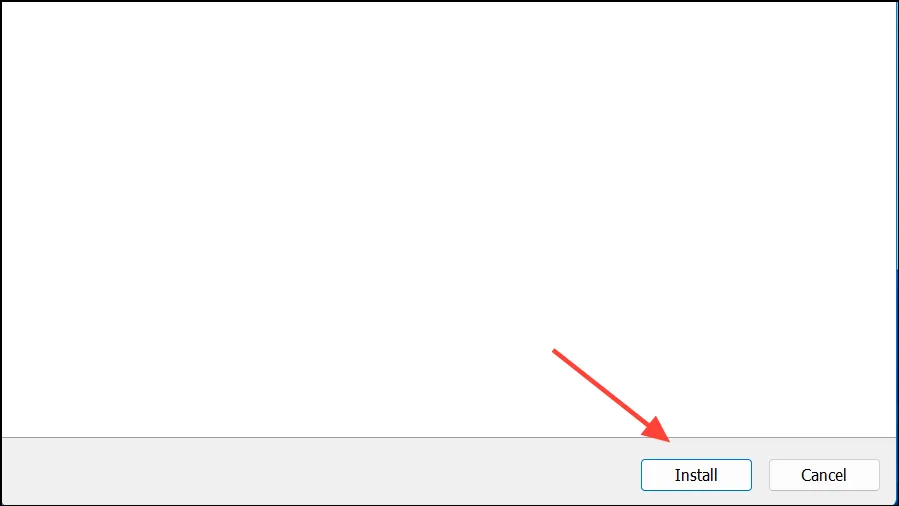

- Po dokončení stahování jej otevřete a nainstalujte do počítače. Po dokončení instalace se instalační program automaticky zavře.

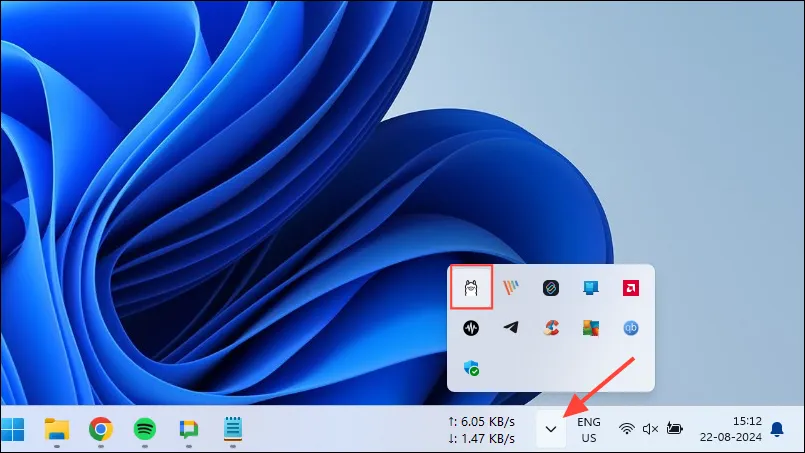

- V systému Windows můžete zkontrolovat, zda je Ollama spuštěna nebo ne, kliknutím na tlačítko přetečení na hlavním panelu pro zobrazení skrytých ikon.

Přizpůsobení a používání Ollama

Jakmile je Ollama nainstalována na vašem počítači, první věc, kterou byste měli udělat, je změnit místo, kde ukládá svá data. Ve výchozím nastavení je místo úložiště, C:\Users\%username%\.ollama\modelsale protože modely AI mohou být poměrně velké, váš disk C se může rychle zaplnit. Chcete-li tak učinit,

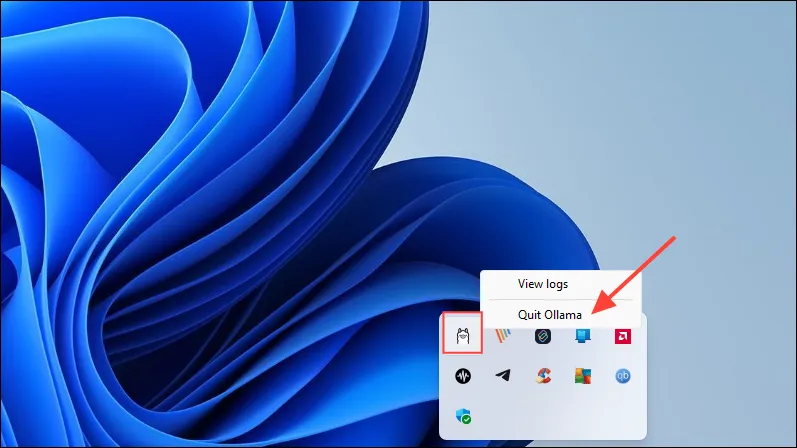

- Nejprve klikněte na ikonu Ollama na hlavním panelu a klikněte na ‚Quit Ollama‘.

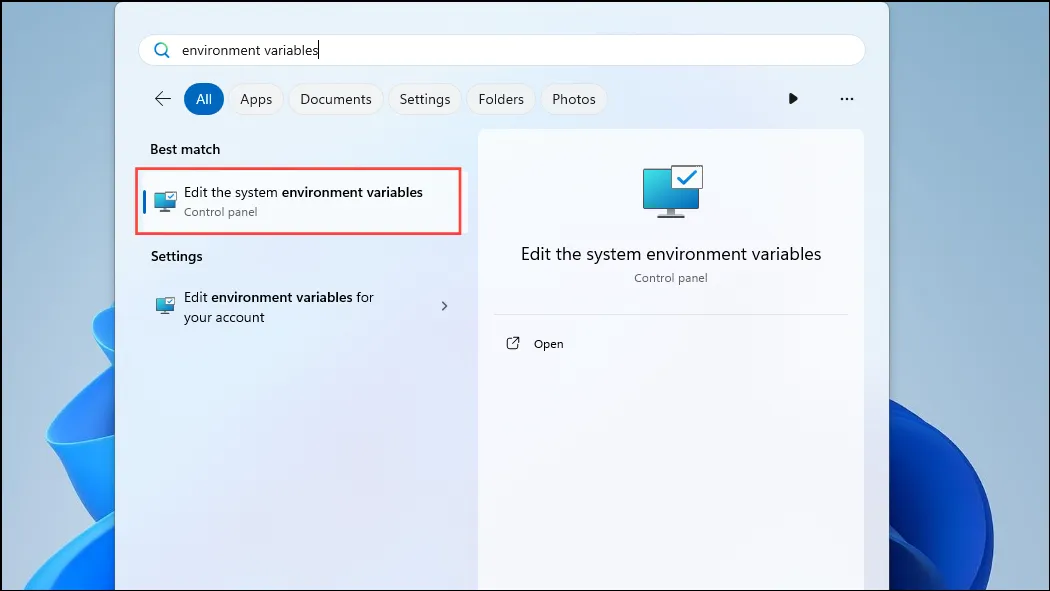

- Jakmile Ollama skončí, otevřete nabídku Start, napište

environment variablesa klikněte na „Upravit systémové proměnné prostředí“.

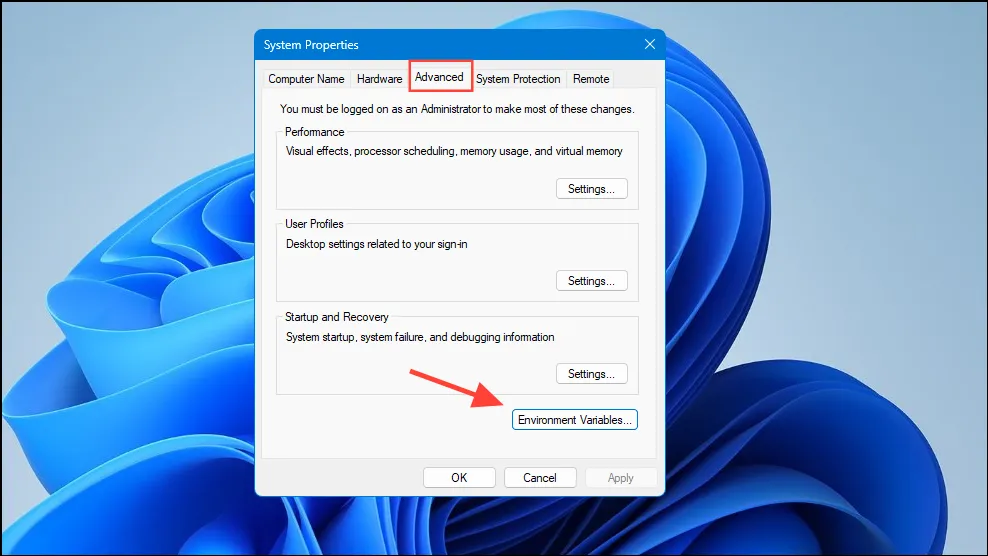

- Když se otevře dialogové okno Systémové proměnné, klikněte na tlačítko ‚Proměnné prostředí‘ na kartě ‚Upřesnit‘.

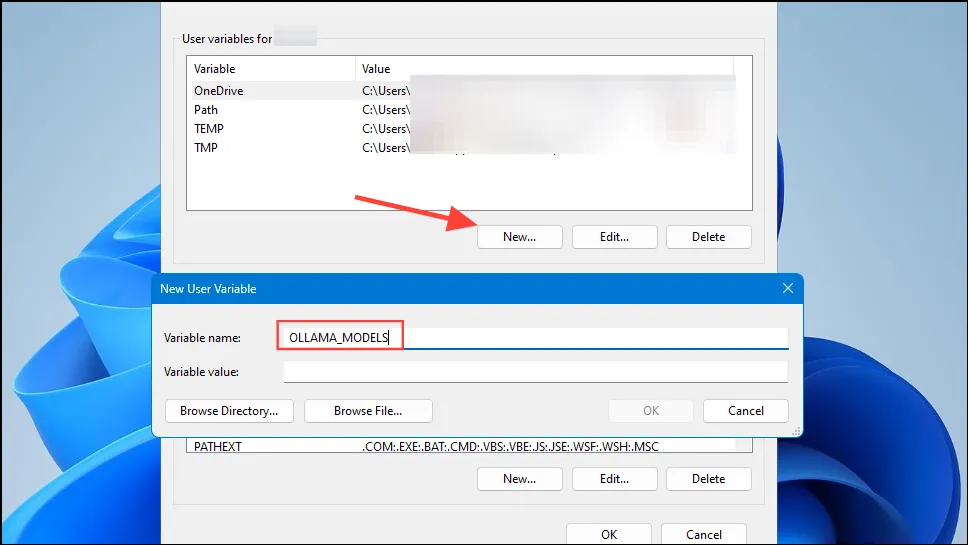

- Klikněte na tlačítko ‚Nový‘ pro svůj uživatelský účet a vytvořte proměnnou pojmenovanou

OLLAMA_MODELSv poli ‚Název proměnné‘.

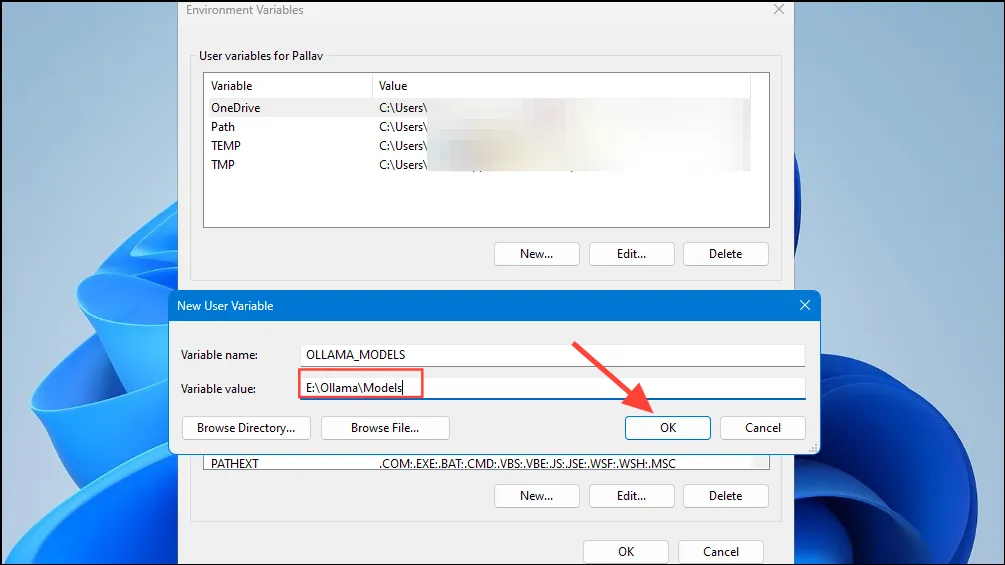

- Poté zadejte umístění adresáře, kam chcete, aby Ollama ukládal své modely, do pole ‚Proměnná hodnota‘. Poté klikněte na tlačítko ‚OK‘ před spuštěním Ollama z nabídky Start.

- Nyní jste připraveni začít používat Ollama a můžete to udělat s Meta’s Llama 3 8B, nejnovějším open-source modelem umělé inteligence od společnosti. Chcete-li spustit model, spusťte příkazový řádek, okno Powershell nebo Windows Terminal z nabídky Start.

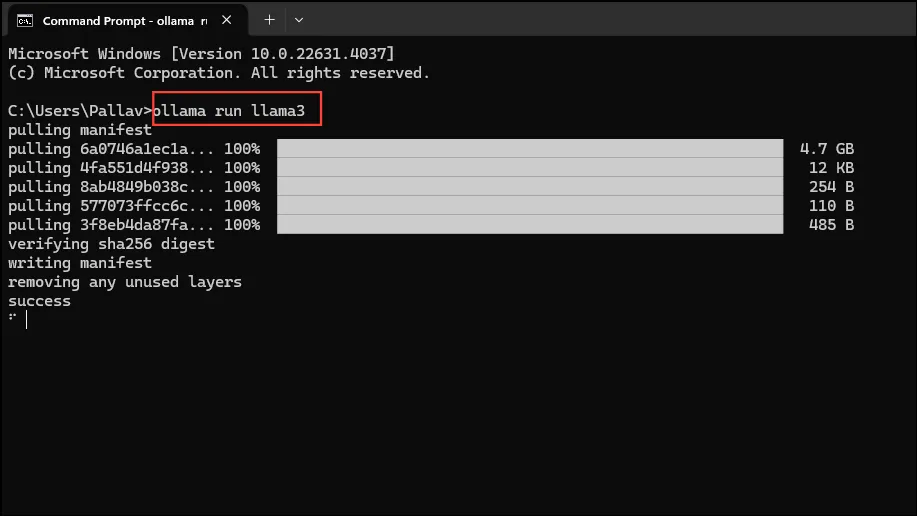

- Jakmile se otevře okno příkazového řádku, zadejte

ollama run llama3a stiskněte Enter. Model se blíží 5 GB, takže jeho stažení bude chvíli trvat.

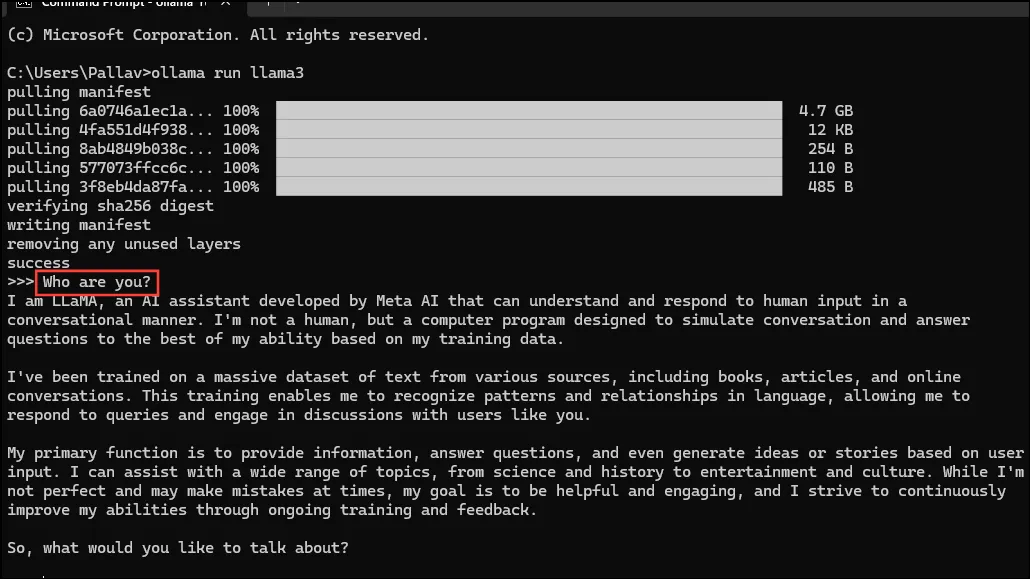

- Po dokončení stahování můžete začít používat Llama 3 8B a konverzovat s ní přímo v okně příkazového řádku. Můžete se například zeptat modelu

Who are you?a stisknout Enter, abyste dostali odpověď.

- Nyní můžete pokračovat v konverzaci a klást modelům AI otázky na různá témata. Jen mějte na paměti, že Llama 3 může dělat chyby a halucinovat, takže byste při jejím používání měli být opatrní.

- Můžete si také vyzkoušet další modely na stránce knihovny modelů Ollama. Kromě toho existují různé příkazy, které můžete spustit a vyzkoušet různé funkce, které Ollama nabízí.

- Při spuštění modelu můžete také provádět různé operace, jako je nastavení proměnných relace, zobrazení informací o modelu, uložení relace a další.

- Ollama vám také umožňuje využívat multimodální modely umělé inteligence k rozpoznávání obrázků. Například model LLava dokáže rozpoznat obrázky generované DALLE-3. Dokáže detailně popsat obrázky.

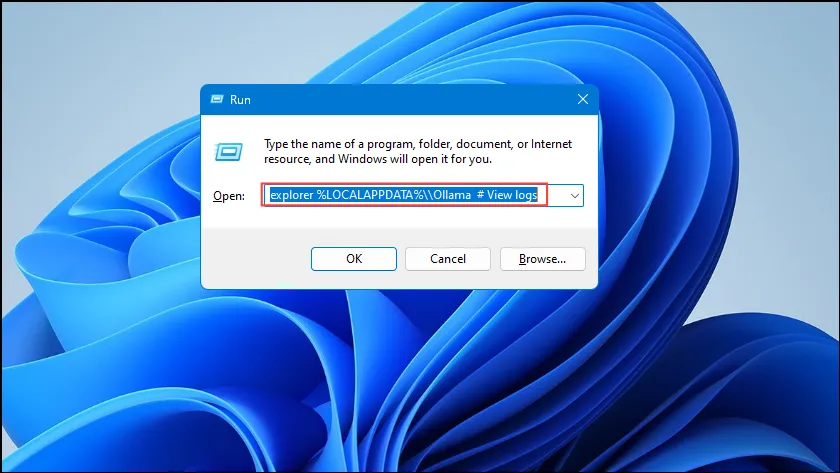

- Pokud při spuštění Ollama narazíte na chyby, můžete zkontrolovat protokoly a zjistit, v čem je problém. Pomocí

Win + Rzkratky otevřete dialogové okno Spustit a zadejteexplorer %LOCALAPPDATA%\\Ollama # View logsdo něj před stisknutím klávesy Enter.

- Můžete také použít další příkazy jako

explorer %LOCALAPPDATA%\\Programs\\Ollamaaexplorer %HOMEPATH%\\.ollamake kontrole umístění binárních souborů, modelu a konfigurace.

Věci, které byste měli vědět

- Ollama automaticky detekuje váš GPU pro spuštění modelů AI, ale na strojích s více GPU může vybrat ten špatný. Chcete-li se tomu vyhnout, otevřete Ovládací panel Nvidia a nastavte Zobrazení na „Pouze Nvidia GPU“.

- Režim zobrazení nemusí být k dispozici na každém počítači a chybí také, když k počítači připojíte externí displeje.

- V systému Windows můžete zkontrolovat, zda Ollama používá správný GPU pomocí Správce úloh, který zobrazí využití GPU a dá vám vědět, který z nich se používá.

- Zatímco instalace Ollama na macOS a Linux je trochu odlišná od Windows, proces spouštění LLM přes něj je docela podobný.

Napsat komentář