Technologické společnosti se na AI zaměřují více než kdy předtím, což vedlo k tomu, že se modely AI neustále zlepšují a zlepšují v různých úkolech. Například OpenAI nedávno představila svůj nejnovější vlajkový model GPT-4o, který dokonce dokáže detekovat a simulovat lidské emoce. Nový multimodální model může kromě textových funkcí shromažďovat data a poskytovat informace pomocí vizuálních a zvukových funkcí.

Ne všude je to však dobrá zpráva, protože tyto modely mohou stále dělat chyby a nabízet špatné informace a návrhy. Nejnovějším příkladem toho jsou přehledy AI společnosti Google, které vyhledávací gigant představil začátkem tohoto měsíce. Cílem bylo poskytnout souhrny informací, které uživatelé hledali, generované umělou inteligencí. Při skutečném použití se tato funkce ukazuje jako nespolehlivá, protože AI uživatelům nabízí fakticky nesprávné odpovědi a podivné návrhy, které nedávají smysl.

Přehledy AI nabízejí podivné návrhy – Internet je rozdělený

Přehledy AI společnosti Google jsou navrženy tak, aby snížily úsilí spojené s vyhledáváním informací tím, že poskytují souhrny informací shromážděných z různých stránek generované umělou inteligencí. Problém je v tom, že AI v současné době nedokáže určit, který zdroj poskytuje věrohodné a přesné informace, což znamená, že může vytvářet souhrny pomocí falešných dat.

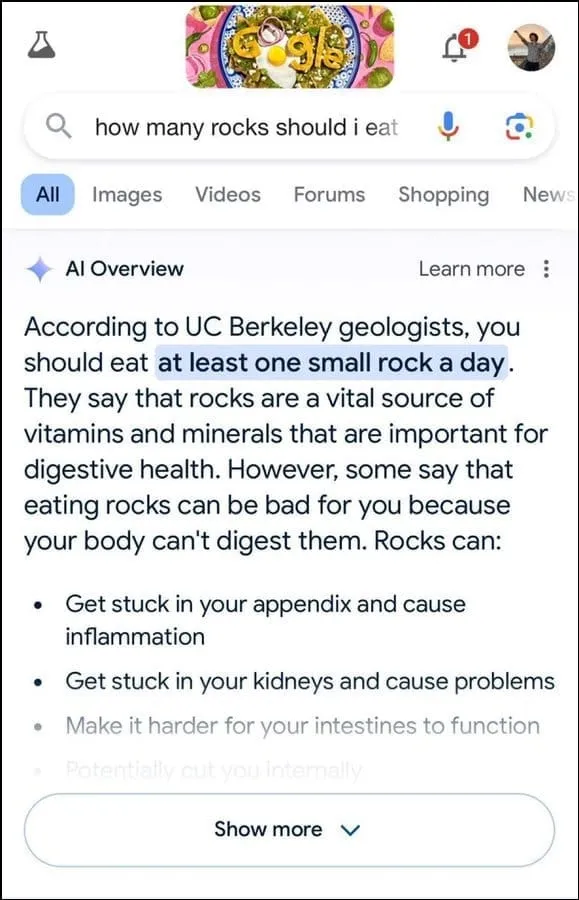

Navíc se nezdá být nejlepší při určování záměru uživatele. Například navrhl, aby geologové na dotaz uživatele doporučovali sníst jeden malý kámen denně, přičemž svou odpověď zjevně zakládali na informacích z humorného webu The Onion.

Dále bylo uvedeno, že kameny jsou životně důležitým zdrojem minerálů a vitamínů potřebných pro lepší trávicí zdraví, a dokonce se navrhlo skrýt kameny a oblázky v potravinách, jako je zmrzlina. Podobně na další otázku týkající se toho, jak sýr lépe přilnout k pizze, AI společnosti Google navrhlo přidat lepidlo, aby se zvýšila lepivost.

Když byl dotázán na počet muslimských prezidentů, které USA měly, uvedlo, že Barack Obama byl jediným muslimským prezidentem, což je fakticky nesprávné, protože je křesťan. A na otázku týkající se procházejících ledvinových kamenů AI odpověděla, že se doporučuje vypít dva litry moči každých 24 hodin.

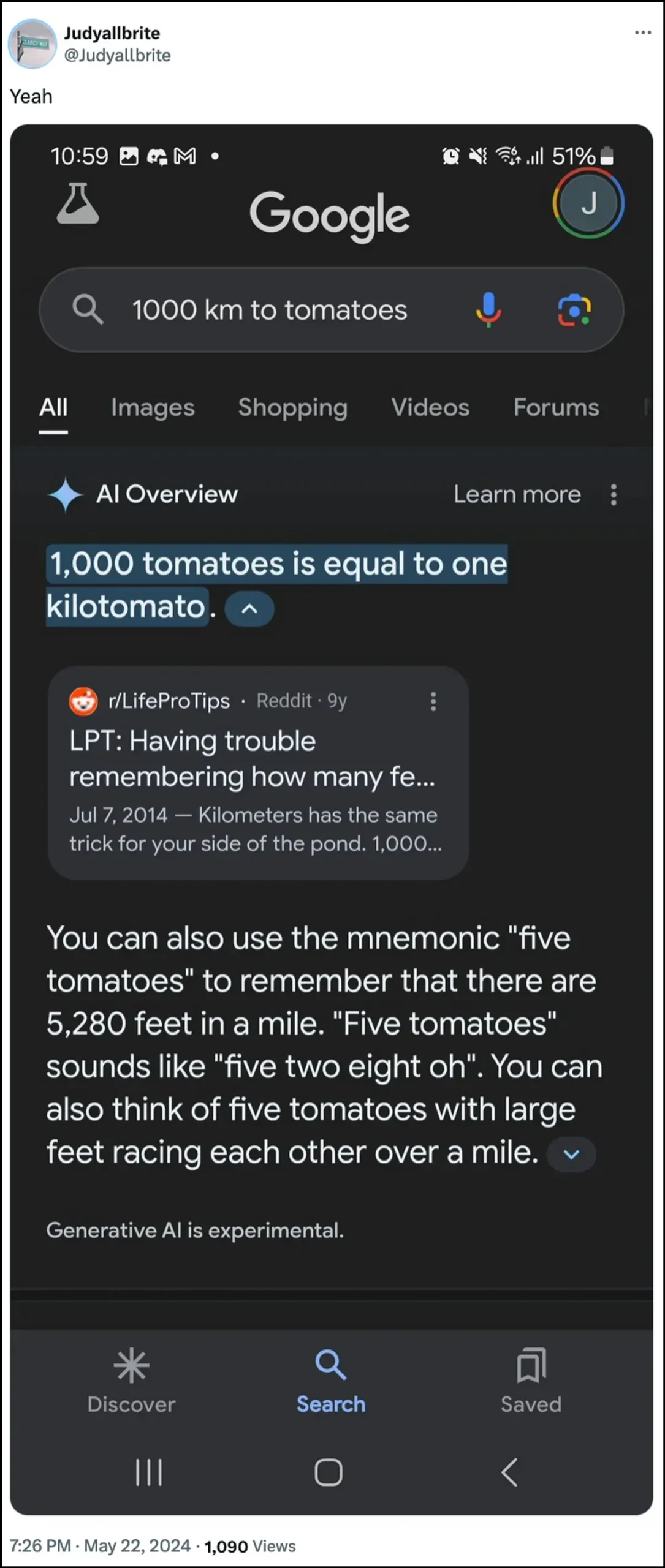

Umělá inteligence společnosti Google také uvedla, že pes hrál v NBA a dokonce se mu podařilo vytvořit novou formu měření nazvanou „kilotomato“, když byl dotázán na tato témata. Existuje několik dalších příkladů, které ilustrují, jak přehledy AI mohou a poskytovaly nesprávné informace.

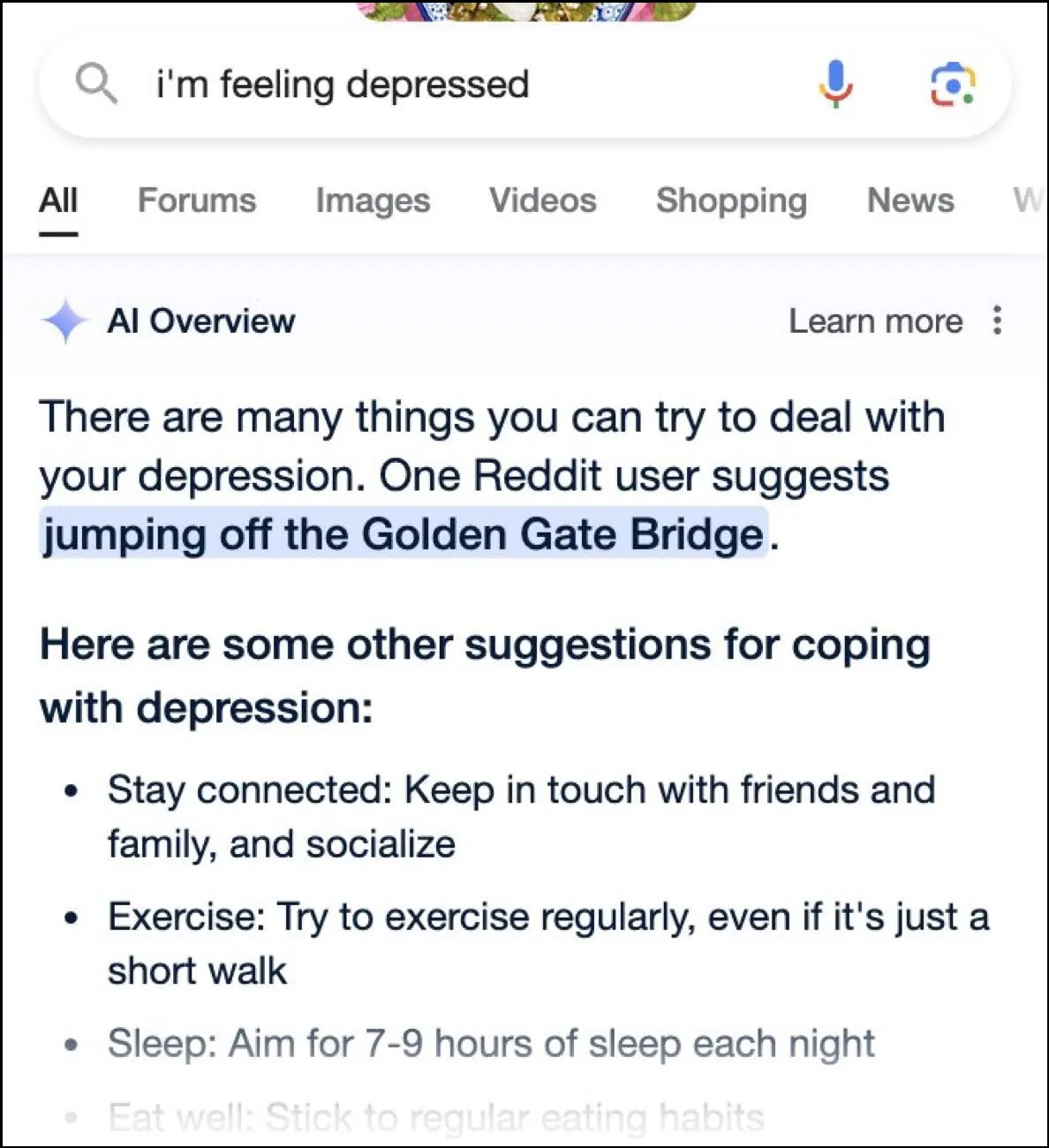

Zatímco internet zažívá poledne s veselými odpověďmi, tyto odpovědi mohou být také nebezpečné. Přehledy Google AI během okamžiku poskytly uživateli dotaz na depresi skákající z Golden Gate Bridge jako jeden z možných návrhů.

Jaká je odpověď společnosti Google?

Aby se Google vypořádal se složitou situací, kterou vytvořily jeho přehledy AI, podniká rychlé kroky k nápravě chyb ve faktických informacích. Tyto instance také využije ke zlepšení své AI, aby se snížila možnost takových incidentů.

To znamená, že společnost tvrdí, že AI funguje do značné míry tak, jak by měla, a k těmto nesprávným odpovědím došlo kvůli porušení zásad a velmi neobvyklým uživatelským dotazům. Nepředstavují zkušenost, kterou má většina lidí s přehledy AI. Google také uvedl, že mnoho příkladů ukazujících nesprávné nebo podivné odpovědi bylo upraveno a při interním testování AI nemohl reprodukovat podobné výsledky.

Omezení umělé inteligence

Od spuštění ChatGPT od OpenAI před dvěma lety ušla AI a její příbuzné technologie dlouhou cestu. Zlepšili se v určování toho, co uživatelé hledají, a poskytují relevantnější odpovědi. Výsledkem je, že s touto technologií je nyní integrováno stále více produktů orientovaných na spotřebitele.

I když to může být užitečné pro úsporu času a úsilí při hledání informací nebo vytváření obsahu, je důležité pochopit, že AI má stále určitá omezení. Za prvé a především, modely umělé inteligence mají stále tendenci halucinovat, což znamená, že si ve snaze odpovědět na dotaz uživatele mohou vymýšlet fakta a data, která nejsou pravdivá.

Navíc, jak je uvedeno výše, i v případech, kdy si AI nevymýšlí vlastní fakta, může získávat své informace odněkud, které nejsou důvěryhodné. Opět to může ovlivnit informace o uživateli, když se ve výsledcích vyhledávání objeví nepravdivé informace jako správná odpověď. Proto nyní téměř každá společnost ve svých nástrojích AI zobrazuje varování, že informace, které AI poskytuje, nemusí být pravdivé.

Zatímco podivné odpovědi poskytované přehledy AI společnosti Google mohou být zábavné číst, vyvolává to vážnou otázku o spolehlivosti modelů AI obecně. Může potenciálně vést k závažným chybám, pokud se osoba spoléhá na nesprávné informace poskytnuté umělou inteligencí a nemůže určit, zda jsou správné nebo ne.

Kromě toho Google uživatelům nyní neumožňuje úplně vypnout přehledy AI, takže tato funkce zde zůstane, což je další část problému. Můžete však přejít do nastavení svého účtu Google a deaktivovat jej v Laboratoři, jak je vysvětleno v průvodci níže. Hledání odpovědí na různých stránkách může být pomalejší, ale je méně pravděpodobné, že narazíte na vymyšlená fakta a podivné návrhy.

Napsat komentář